|

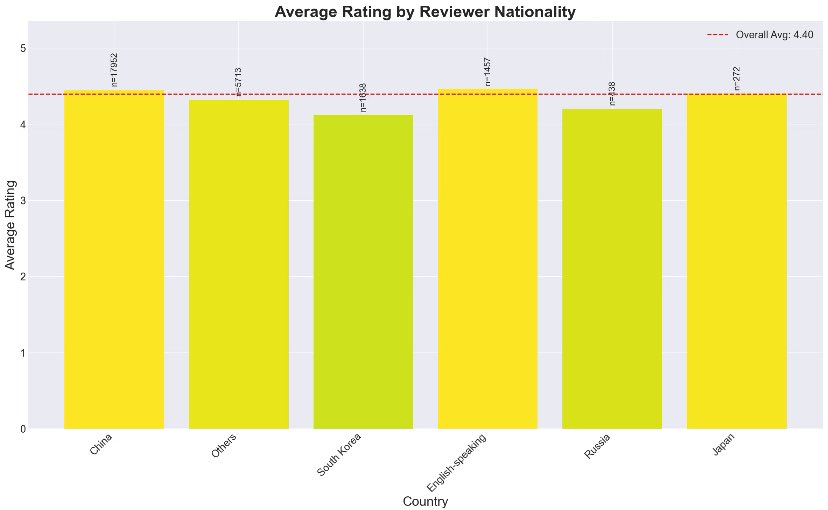

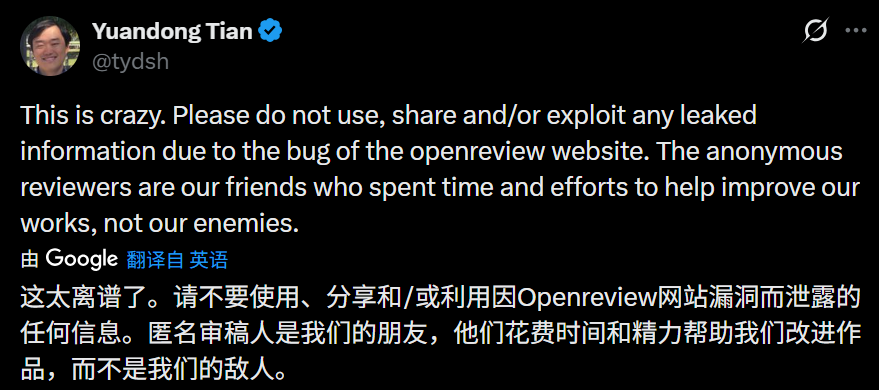

一夜无眠! 北京时间 11 月 27 号深夜,学术审稿平台 OpenReview 的一个前端漏洞,让整个学术界集体沸腾 —— 原本藏着掖着的双盲评审(作者和审稿人互相匿名),突然变成了 "明牌互认",操作简单到让人绷不住。 只要在浏览器里输入一段特定网址,手动替换论文 ID 和审稿人编号,就能直接扒出谁给你的论文审的稿、打了多少分。 没有技术门槛,不用复杂操作,相当于把审稿人的身份信息直接摆到了台面上。这一下,不管是曾经被恶意打低分的,还是好奇谁在背后评价自己研究的,全开启了 "查岗模式"。 微信群、社交平台里全是实锤爆料:有人翻出自己半年前被拒的论文,发现打 1 分的审稿人,五个月后就发了同赛道论文,还故意不引用自己的研究,明摆着 "抢成果"; 有人碰到组内同行互相使绊子,私下给对方论文打低分;还有人吐槽,有的审稿人连论文核心观点都没看懂,就随便写了句 "逻辑不清" 给拒了。 更戏剧的是,不少被 "扒出来" 的恶意审稿人,怕被作者报复或影响学术声誉,连夜修改评分,把原本的差评改成 "建议接收",反差大到让人咋舌。   网友调侃,这哪里是学术评审,分明是从 "暗戳戳的黑暗森林" 变成了 "全民围观的公开处刑",直接把 AI 顶会审稿的矛盾推到了顶点。 更离谱的是,这漏洞还是系统级的 "硬伤"—— 稍微改改网址里的字符,不光能查今年 ICLR 的审稿信息,连 NeurIPS、ICML、ACL 这些 往年的评审数据都能扒出来,相当于把历年顶会的评审 "黑历史" 全翻了出来。 其实顶会审稿质量下滑早有吐槽。现在 AI 领域太火,投稿量暴增到离谱,ICLR 2026 光投稿就有 19490 篇,对应的评审意见高达 75800 条,但靠谱的审稿人根本不够用。之前就有机构统计,ICLR 2026 里 21% 的评审意见是纯 AI 生成的,一半以上的评审都用了 AI 辅助;另一方面,也有 199 篇投稿论文被发现是纯 AI 写的,9% 的论文一半以上内容都是 AI 生成的,相当于 "AI 审 AI 写的论文",离谱程度拉满。 直到周五零点左右,这个漏洞才被紧急修复。ICLR 官方立马发声明,态度强硬:谁要是敢用、传播这些泄露的信息,直接拒稿 + 终身禁赛,后续还会追究责任。OpenReview 也跟着发了公告,但根本拦不住大家吃瓜 —— 有人把所有审稿人信息爬下来做数据分析,整理出 "低分收割机" 排行榜;还有人统计不同国家审稿人的打分习惯,发现咱们国人打分偏宽松,韩国审稿人相对最严格。  网友开玩笑说,照这个速度,说不定很快就能查出今年 NeurIPS 上写 "Who's Adam?"(暗指审稿人不专业,连 AI 基础概念都不懂)那个 "奇葩审稿人" 是谁了。 学界大佬也绷不住了,加州理工教授、ICLR 前主席 Yisong Yue 直接在社交平台吐槽:"得赶紧开个紧急会议,我已经麻了。"  说到底,这事儿最伤的是学术公平。审稿人匿名本来是为了敢说真话、大胆提批评意见,不用怕得罪人;现在身份暴露,以后谁还敢说真话?作者知道了审稿人是谁,也可能去求情甚至报复,原本的平衡全被打破了。 但反过来想,之前也有不少不负责任的恶意评审,借着匿名当 "遮羞布",这次事件闹这么大,也该让学术界好好反思:学术评审到底该怎么搞,才能既保证公平,又能守住专业底线?  这场 "审稿大泄密",算是给学术界敲了个响警钟 —— 匿名不是恶意评审的保护伞,公平透明才是学术研究的根儿。  天玑算·科研服务,致力于为高校、科研院所及研发型企业提供模拟计算、超算租用、服务器定制、学术培训与实验检测等科研一体化解决方案。公司拥有50余名全职硕博工程师及千余名认证技术人才,构建了覆盖20多个细分领域的专业计算体系,累计服务超2000家单位、覆盖超10万科研人员,业务遍及全国30余省市,以扎实的服务网络践行“科研报国”的企业使命。

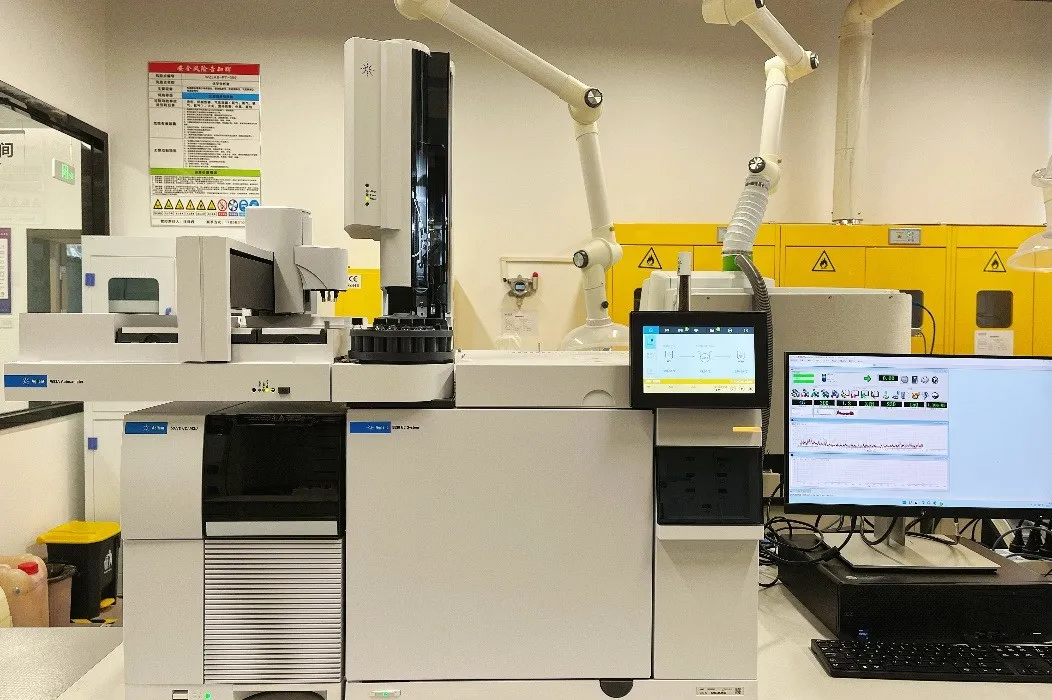

在基础设施方面,投入上亿元,在成都、雅安、广西建立3大战略级算力中心,采用Intel至强铂金五代、AMD霄龙四代等业界领先架构,构筑极速高效的HPC算力基石。并由专业团队自主研发“天玑智算云”平台实现异构计算资源智能调度,同时具备从设计到生产的全链条服务器定制能力。 在基础设施方面,投入上亿元,在成都、雅安、广西建立3大战略级算力中心,采用Intel至强铂金五代、AMD霄龙四代等业界领先架构,构筑极速高效的HPC算力基石。并由专业团队自主研发“天玑智算云”平台实现异构计算资源智能调度,同时具备从设计到生产的全链条服务器定制能力。    在实验支撑层面,天玑算自建符合国际标准的实验室,引进赛默飞、布鲁克等顶尖设备,为科研提供可靠的实验保障。在知识赋能方面,系统化构建了“天玑智研”学术共享平台,通过全终端覆盖,为科研工作者提供6000余个视频课时,全网播放量突破1000万次。     通过计算、算力、实验与知识的深度融合,天玑算构建了从基础研究到成果转化的完整服务闭环,以专业实力践行科研报国理念,持续助力中国科研事业创新发展。 关注分享 让科研更轻松 本文由天玑算整理撰写,相关内容来毕导、国科大杭州高等研究院等,版权归原作者所有,不代表本公众号观点或证实其内容的真实性,如侵权请联系删除,谢谢!

|  |Archiver|手机版|小黑屋|Octave中文网学术交流论坛

( 黑ICP备2024030411号-2 )

|Archiver|手机版|小黑屋|Octave中文网学术交流论坛

( 黑ICP备2024030411号-2 )